Innehållsförteckning

När nu en ny generation gör intåg står en aspekt ut; denna gång behöver tillverkarna slåss om oss konsumenter på ett mer aggressivt sätt. Hur lockar man spelare till dessa nya grafikkort, och vad exakt är säljargumenten för de, särskilt när de kostar många tusenlappar? Detta är något vi vill undersöka med MSi Geforce RTX 4090 Gaming X Trio; ett så överpresterande grafikkort att vi tappar hakan, i alla fall initialt! Frågan är hur den klarar sig i det långa loppet?

Inledning

Låt oss få detta ur vägen; detta grafikkort är väldigt dyrt. Ni vet det, jag vet det. Detta är inte ett grafikkort gjort för användare av FullHD monitorer (1080p) och till viss del ens QHD (1440p) utan är istället bäst utnyttjat på 4K (2160p) skärmar. Det är helt enkelt en flaggskeppsprodukt, som riktar sig mot de användare som vill ta del av det absolut högsta skiktet av spelprestanda, och genuint är villiga att betala för detta. Om du inte är en av dessa – ja då kan jag stoppa dig redan här. Då är det recensioner av grafikkort i det (troligtvis) betydligt mer logiska mellansegmentet istället något du bör hålla koll efter. Men trots det ska jag ändå ge detta ett försök – där jag faktiskt fokuserar på vilken publik det riktar sig mot, och framförallt testa hur väl detta kort faktiskt presterar. Är det ens är värt att skaffa MSi Geforce 4090 Gaming X Trio, om du faktiskt är en del av den specifika publiken som detta riktar sig mot.

Metodik och idé

Metodiken består av följande upplägg; först rena jämförelser mot senaste 30xx-serien från Nvidia samtidigt som en jämförelse görs utifrån två processorserier. Dels Intels i5 12600 som representerar en nyare men betydligt mer budgetorienterad processor, medan vi sedan även använder Intels mest högaktuella högkalibersprocessor Intel i9 13900K.

Poängen med detta är att ge en mer representativ bild för hur RTX 4090 presterar på en äldre/lägre nivå av processor – och sedan jämföra den processorns grafikprestanda med den nuvarande ’top-of-the-line’ processorn – och hur RTX 4090 presterar där.

Samtliga tester görs i 1080p, 1440p och 2160p (med senaste grafikkortsdrivrutinerna per 2022-11-01) – där den senare upplösningen är detta grafikkorts ’sweetspot’. Redan nu kan jag säga spoila att RTX 4090 blir CPU-bundet (tänk processorflaskhals) i merparten av 1080p titlar – och likaså många 1440p titlar, vilket än en gång vittnar om dess prestanda. Trots detta finns det ändå tydliga uppgångar i prestanda bara genom att byta upp sig sett till processor – eller till och med på en äldre processor, men med detta nya grafikkort. Efter samtliga tester kommer vi även beröra DLSS 3.0 Frame Generation och strömförsörjningen av detta grafikkort.

Alla processorer har ett tak på antal instruktioner de kan göra. Ju bättre processor, desto fler instruktioner kan skickas ut. I spelsammanhang spelar dock oftast grafikkortet mer roll – och då det i sig konstant skickar instruktioner till processorn att tolka och behandla kan det bli en flaskhals om mängden instruktioner från grafikkort helt enkelt överskrider vad processorn hinner med.

Har du t.ex. en äldre/svagare processor än grafikkort, kan det alltså ske att processorn inte kan hålla jämna steg med grafikkortet, och därför nås inte grafikkortets fulla potential.

CPU-bundna situationer är dock naturligt – och GPU-bundna likaså, då varken en processor eller ett grafikkort är oändligt presterande. Det kommer alltså alltid finnas en flaskhals någonstans. Därför handlar det oftare om att hitta två jämbördiga produkter för att de på det sättet ska kunna utnyttjas mer optimalt.

Förtydligande kring våra testdatorer

Poängen med att ha med en dator i mellansegmentet är i korthet att försöka replikera en dator som flest människor kan tänkas ha – sett till dess mer jordnära prestanda. Undantaget är att vi valt ett B660 moderkort med DDR5 RAM minne. Dels är det för att DDR4 minnen idag är någorlunda jämförliga i prestanda, men även för att vi ska kunna använda samma typ av RAM minne på båda datorer och därmed förhoppningsvis få mer jämförlig data.

Varför jämföra med enbart RTX 3080 och RTX 3070!

RTX 4090 är menat som det högsta ’high-end’ kortet, medan RTX 3080 mer representerar värdepropositionen – i alla fall i kontrast till RTX 4090. Dessutom kostar RTX 4090 just nu nära vad RTX 3080 låg på vid sin release, vilket blir ytterligare en gemensam nämnare att jämföra med. Vi kommer även inkludera RTX 3070 för att ge mer spann, och tydligare jämförelse neråt i ledet. Skulle det därför vara som så att ni är nyfikna på andra grafikkort och deras prestanda – rekommenderar vi att kika in följande recension; MSi Geforce GTX 1660 Super Gaming X.

Är denna typ av uppgradering värd att göra om du redan sitter med en RTX 3080? Tanken är att ge er som använder er av ett sådant grafikkort, en tydlig inblick i potentiell utökning i prestanda, men även vad man faktiskt får för den större prisbilden hos RTX 4090 på ett mer generellt plan.

Snabb överblick och specifikationer

För detta grafikkortstest, kommer vi ta del av benchmarktester från elva relativt nya spel, samt jämförelser mellan RTX 3070, RTX 3080 och RTX 4090 på följande testsystem:

System 1:

Intel Core i5-12600 @ 4.8Ghz (Maxboost)

Corsair Vengeace 32GB @5200 RAM

ROG Strix B660-I gaming Wifi

Operativsystem: Windows 11 Home 64-Bit

Använda upplösningar: 1080p, 1440p & 2160p

Grafikkortsdrivrutiner: Nvidia Drivers 526.47 (30-serien) 522.30 (40-serien).

System 2:

Intel Core i9-13900K @ 5.8Ghz (Maxboost)

Corsair Vengeace 32GB @5200 RAM

MSi MAG Z790 Carbon Wifi

Operativsystem: Windows 11 Home 64-Bit

Använda upplösningar: 1080p, 1440p & 2160p

Grafikkortsdrivrutiner: Nvidia Drivers 526.47 (30-serien) 522.30 (40-serien).

Samtliga tester är gjorda utan V-sync aktiverat, samt att uppskalningstekniker (DLSS, FSR etc.) ej är aktiverade. Varje spel har som lägst profilen ’High’ eller ’Ultra’ i grafikinställningar, och den mix av grafiklägen sinsemellan de olika spelen har valts för att variera upp processen och skapa mer insikt till hur grafikkorten presterar under olika förhållanden. Då användare ändå varierar sina inställningar, gör även vi det. Därför kan det vara intressant att se både när grafikkorten pressas till det extrema såväl som när de ligger på en mer rimlig nivå (sett till grafikkortsinställningar). Givetvis används ej Raytracing – dels för att utgå enbart från ren rasteriseringsprestanda, men framförallt för att datan ska vara lättare att få en ärlig jämförelse mellan.

Som vi nämnde tidigare har vi dels i5 12600 som motsvarar en mer ”gemene man” approach. Denna dator representerar vad du kan tänkas sitta på idag, d.v.s. en mer budgeterad dator. Motpol till detta har vi även i9 13900K där vi låter grafikkortet nå sin maxnivå – med en så minimerad CPU flaskhals som möjligt (till dags dato). Dessa två plattformar kommer agera grundstomme i recensionen, vilket samtliga spel jämförs på. Jämförelser sker även mellan grafikkort, och vi vill även belysa hur mycket du kan få i upplyft genom att bara uppgradera processorn.

Håll uppe grafikkortet! (Pga litet chassi använde vi oss av vår egen GPU Sag Bracket – Ej den medföljande från MSi)

Prestanda och speltester

När det kommer till våra benchmarktester, valdes elva spel ut – alla både relativt nya, men framförallt varierade. Det finns därför några spel som är något äldre (cirka tre år gamla i skrivande stund) och mer nyutkomna sådana. Användare kommer ändå spela både äldre och nya spel så varför inte låta det representeras i spelen.

För varje spel gjordes tre omgångar av benchmarks per grafikkort – plus att MSi Geforce RTX 4090 Gaming X Trio fick ytterligare en omgång bara för att bekräfta datan. Den samlade datan kan ses nedan, och är svaret av omgångarnas resultat i genomsnitt sett till bilduppdateringsfrekvens (FPS).

Obs! Givetvis kan grafikkorts prestation variera mycket från spel till spel, därför försöker vi räkna ut procentuella skillnader i den mån det går. Dock är det viktigt att poängtera att det alltid finns variationer där ute bland spel; beroende på vilken tillverkare en utvecklare främjat eller hur väl drivrutiner optimerats. Dessa elva spel vi valt ut ska inte ses som det ”ultimata” svaret, utan mer som en antydan om var grafikkorten i fråga står.

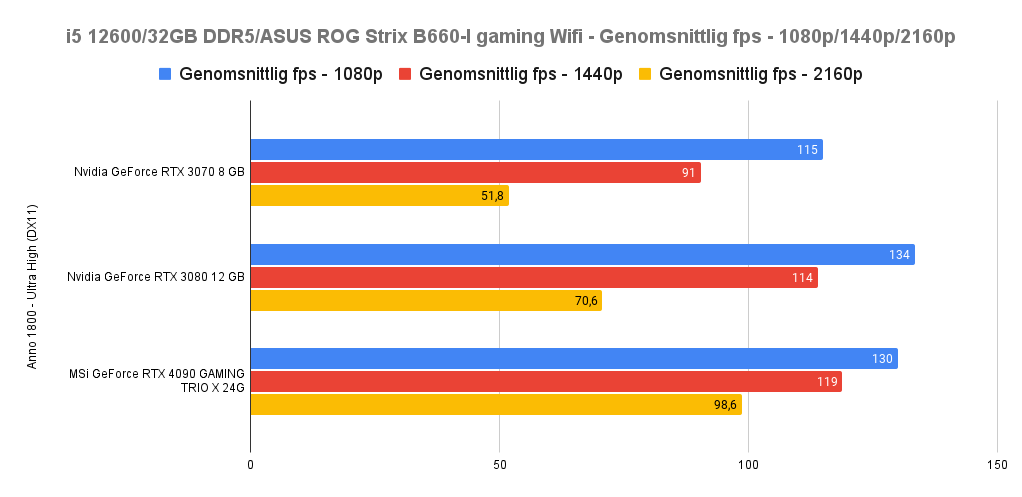

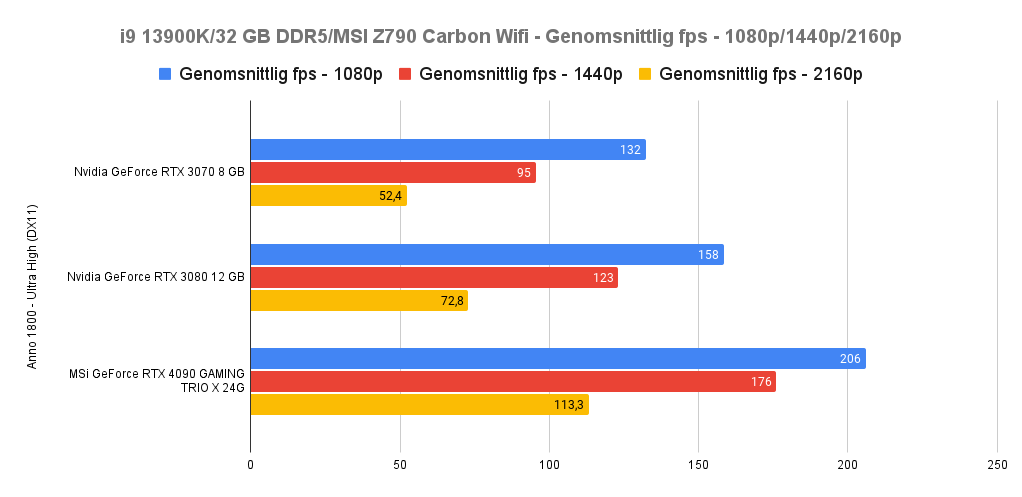

Anno 1800 (Ultra High – DX11) – i5 12600 vs i9 13900K

Anno 1800 är först ut och detta spel är i regel mer CPU krävande än många andra – men just därför var det intressant att addera. Vad som blir tydligt på den svagare processorn i5 12600 är att samtliga grafikkort presterar nära varandra i 1080p och till viss del 1440p. Det är i 2160p (4K) som MSi:s RTX 4090 drar ifrån rejält – och processorn till trots ändå är hela 39,6% snabbare än RTX 3080.

Om vi istället ser till den nyare i9 13900K blir det tydligt att vi kan öka samtliga upplösningars (som sagt vi underlättar ev. processorflaskhalsar nu) uppdateringsfrekvens (FPS). Bara genom att ha uppgraderat processor lyckas både 1080p och 1440p höjas med i genomsnitt 16%. Ser vi istället till 1080p är det hela 61,6% upplyft genom att köra den nyare processorn – och 48% upplyft i 1440p. I 4K (2160p) är det en mer ödmjuk uppgång med cirka 15% från 12600 till 13900K.

Att Anno 1800 är därför ett bra exempel på hur CPU flaskhalsar kan underlättas vid en uppgradering. Men det är även ett tydligt exempel på hur MSi Geforce RTX 4090 Gaming X Trio lyckas ploga fram ordentlig prestanda oavsett plattform. Imponerande!

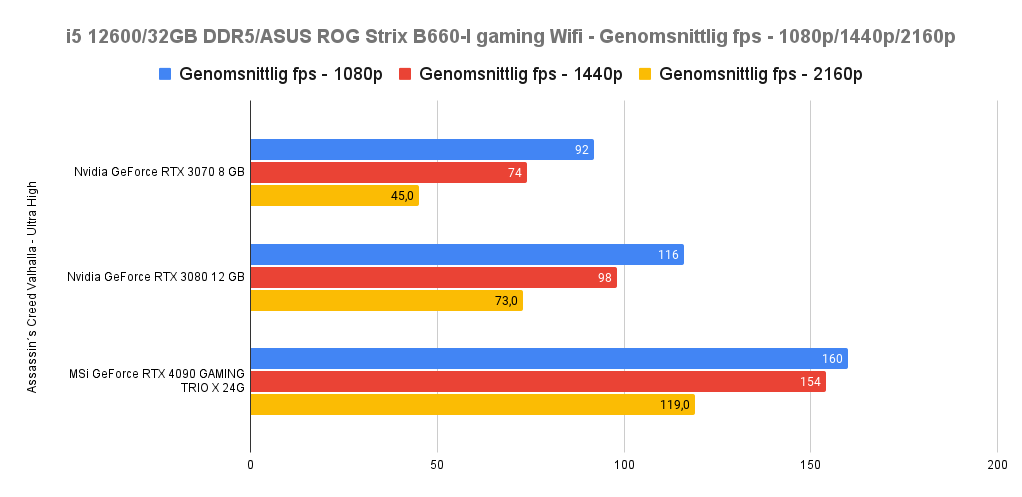

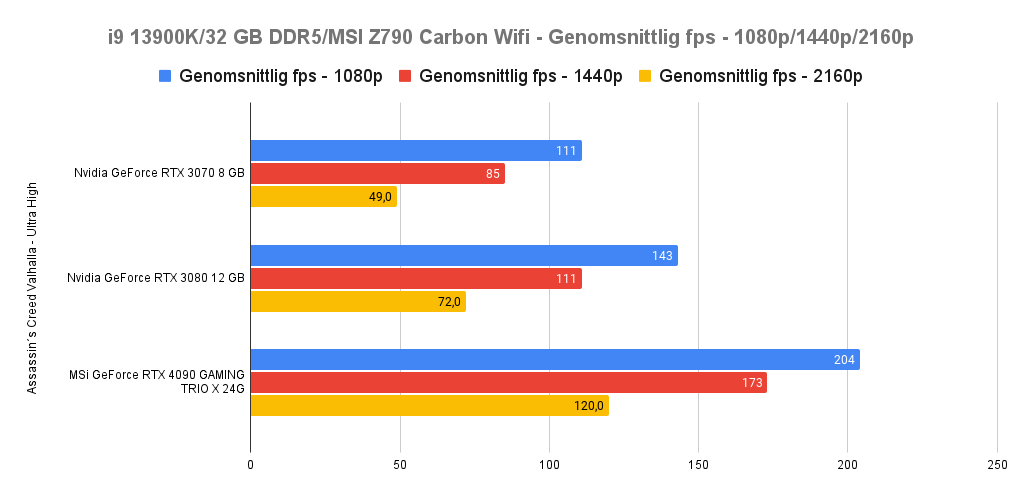

Assassin´s Creed Valhalla (Ultra High) i5 12600 vs i9 13900K

Assassin´s Creed serien gynnas i regel av AMD:s kort, men trots det kan man lugnt säga att RTX 4090 trycker sig igenom utan några problem – i alla upplösningar.

På i5 12600 plattformen springer RTX 4090 ifrån i alla upplösningar; 1080p ser en 38% uppgång från RTX 3080, 1440p ser en 57% uppgång från RTX 3080 och i 4K ser vi hela 63% uppgång. Det är tydligt att grafikkortet är en mastodont även på äldre datorer – även om processorn håller tillbaka den.

Denna gång finns ingen uppgång i 4K om man byter till 13900K (den är alltså fullt GPU bunden här), men givetvis ser vi bra utveckling i 1080p och 1440p. Det som står ut med detta spel är uppgången i 1440p oavsett om du befinner dig på i5 12600 eller i9 13900K; här ser vi i snitt en 56% i förbättring jämfört med RTX 3080.

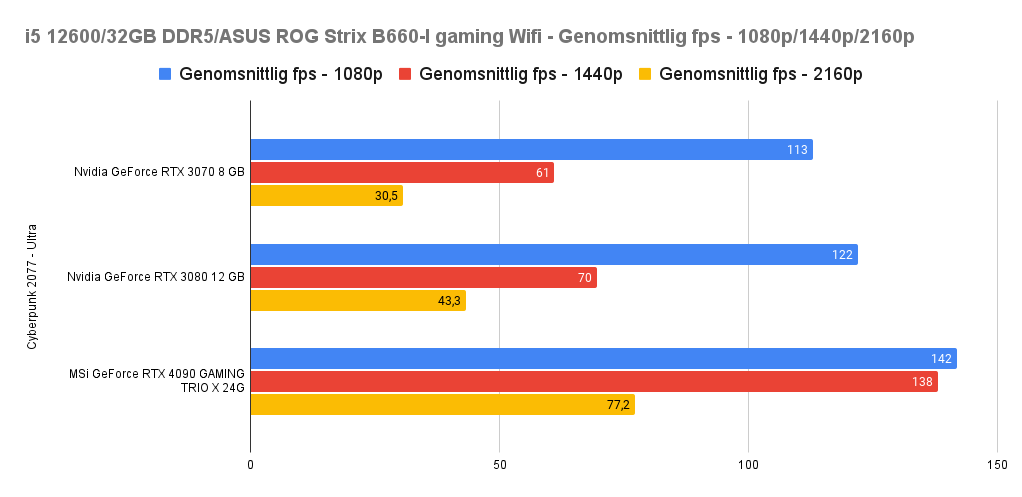

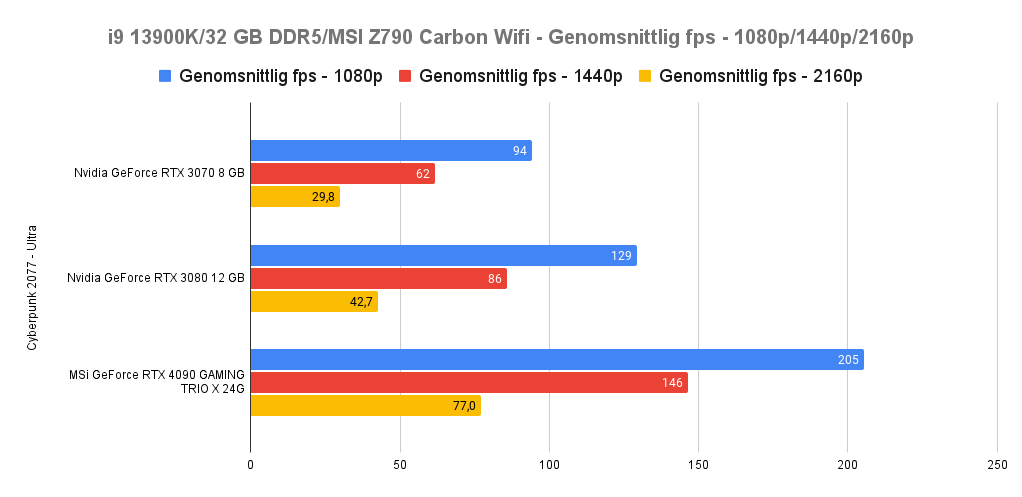

Cyberpunk 2077 (Ultra) ) i5 12600 vs i9 13900K

Inget härdar ett grafikkort såsom Cyberpunk – och nog finns det intressanta saker att belysa här. På den äldre processorn visar både RTX 3070 och RTX 3080 att de snabbt blir CPU bundna – men att trots detta lyckas RTX 4090 pusha ifrån med 16% jämfört mot RTX 3080. När vi sedan går upp till 1440p ser vi 98,5 % utökning i prestanda(!) och 78,5% i 2160p. Den råa kraften som finns i RTX 4090 är därför extra tydlig här.

Vad som dock blir tydligt med specifikt detta spel är att det oavsett processor är väldigt välutnyttjat sett till grafikkraft – och till och med ger vissa grafikkort inget uppsving i FPS trots ny plattform (i ett fall sämre t.o.m). Enbart 1080p skiljer sig plattform till plattform där RTX 4090 får 44% uppsving om man jämför i5 12600 mot i9 13900K.

Det är intressant data, men i fallet med RTX 4090 är det relativt poänglöst (enligt min mening iaf) att ens använda detta kort för 1080p. Ska man spela Cyberpunk 2077 med detta grafikkort är det 1440p minst som gäller.

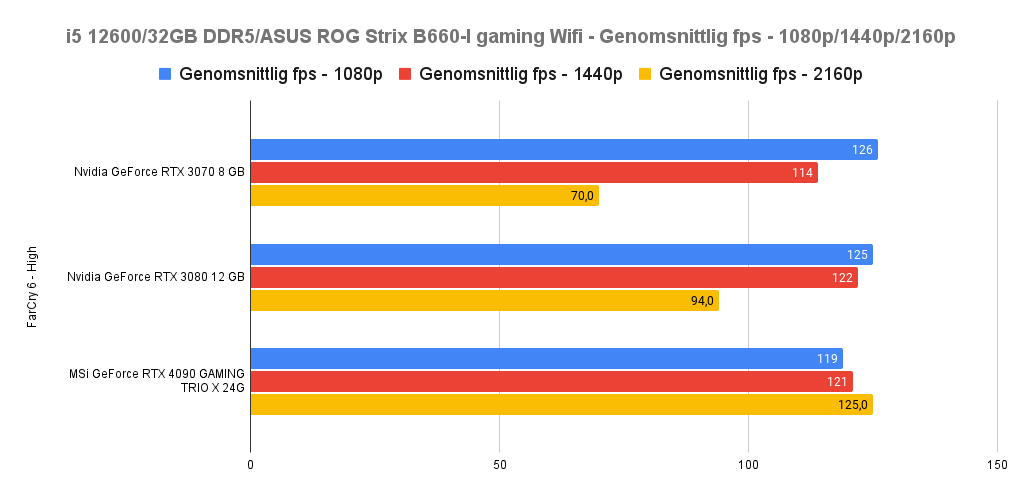

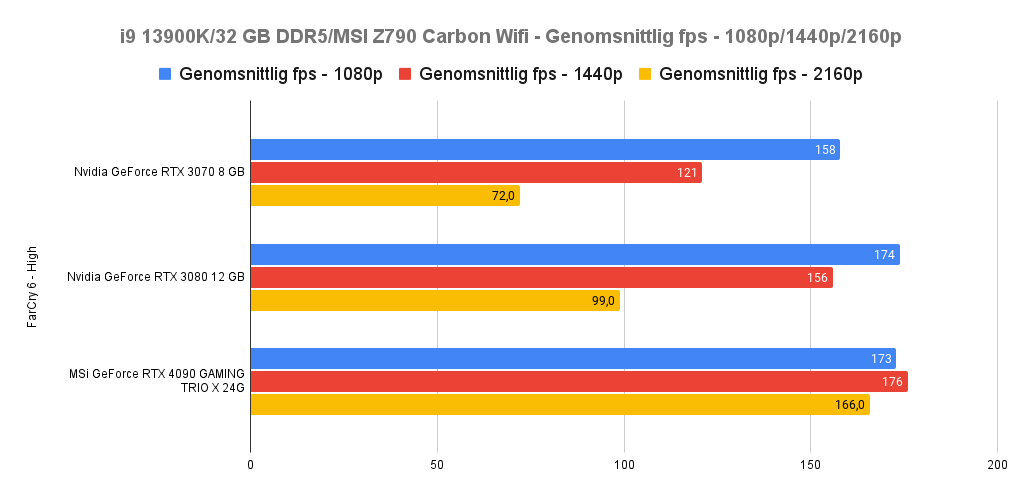

Far Cry 6 (High) i5 12600 vs i9 13900K

Far Cry 6 utmärker sig på det sättet att det i 1080p ger lite försprång för RTX 4090 gentemot de andra grafikkorten. Med andra ord tydligt flaskhalsat. För i5 12600 plattformen fortsätter det även vara flaskhalsat på 1440p och ger först tydliga skillnader sinsemellan grafikkorten i 2160p. Grafikkorten får verkligen sträcka på sig där, och vi ser strax över 30% utveckling från grafikkort till grafikkort. D.v.s från RTX 3070 till RTX 3080, och från RTX 3080 till RTX 4090.

Med en äldre processor är det därför inte alls lika stor utveckling i den högsta upplösningen som jag velat se utan är istället aningen mer blygsam rent procentuell. På i9 13900K ser vi hela 67% utveckling från RTX 3080 till RTX 4090, men för att detta ska vara verklighet behöver du investera i en sprillans ny processor.

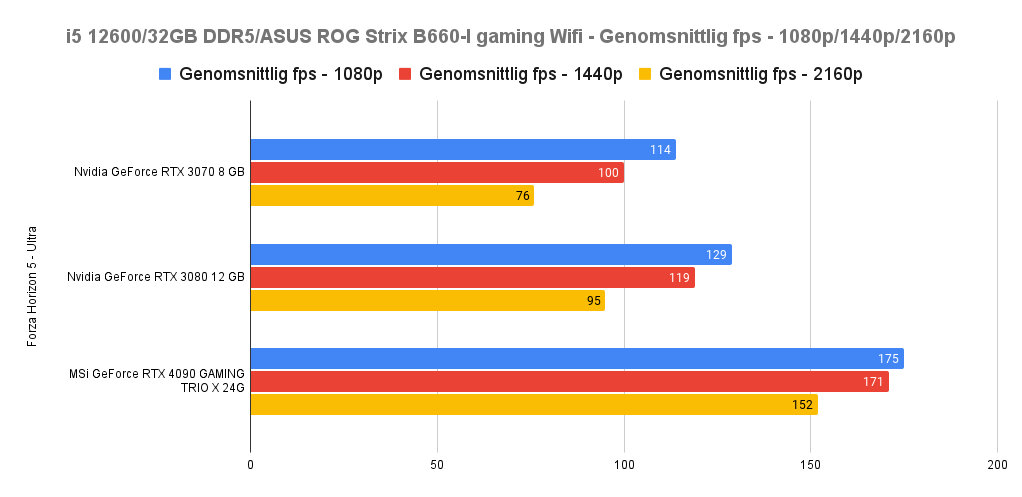

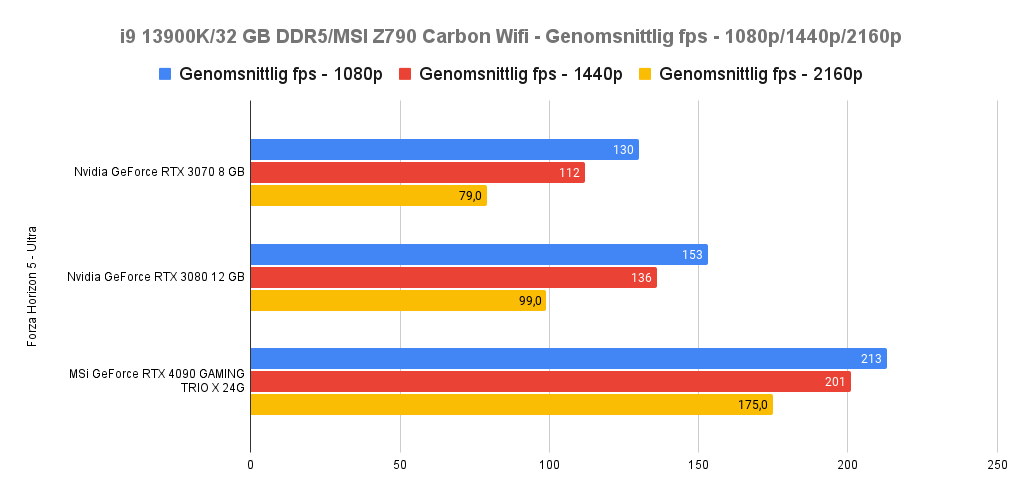

Forza Horizon 5 (Ultra) i5 12600 vs i9 13900K

Microsofts moderna klassiker som är Forza Horizon 5 är intressant ur synpunkten snabbhet. Snabbhet i uträkningar sett till fysik, men även spelets hastighet när du flyger fram i högupplösta världar. Därför var det kul att se att RTX 4090 gav en rejäl boost på båda plattformarna. Spelet är bra optimerat, även om det märktes att det var CPU bundet upp till 1440p – men trots det levererade grafikkortet en uppgång på 35% i 1080p och 44% i 1440p. Ja, den är som sagt processorbunden här, men grafikkortets rena kraft pressar fram ett gäng nya ’frames’.

Om vi ser till i9 13900K blir RTX 4090 på riktigt ett monster, och ger i 2160p hela 77% ökning! Från RTX 3080:s 99 FPS till hela 175 FPS, och cementerar hur stort detta generationsvisa utveckling. Även 1080p får en 40% boost och 48% ökning i 1440p gentemot RTX 3080.

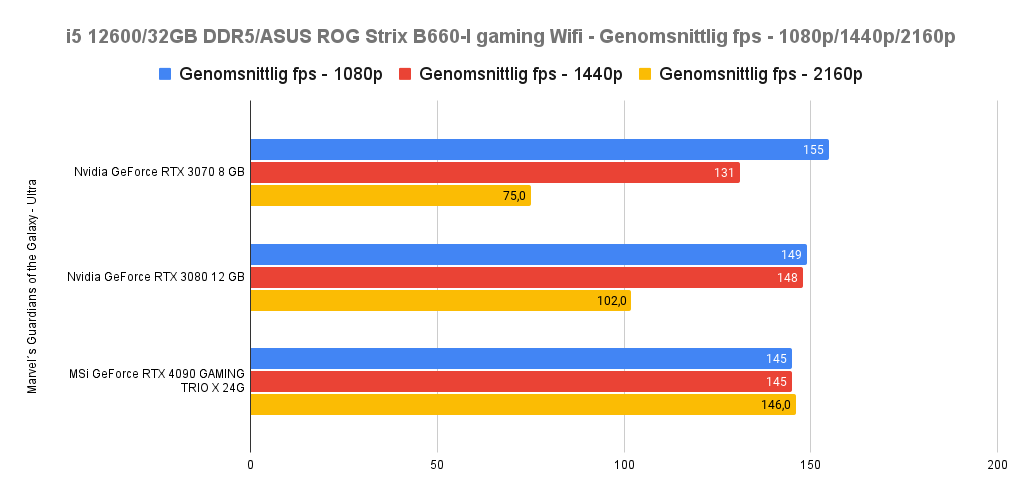

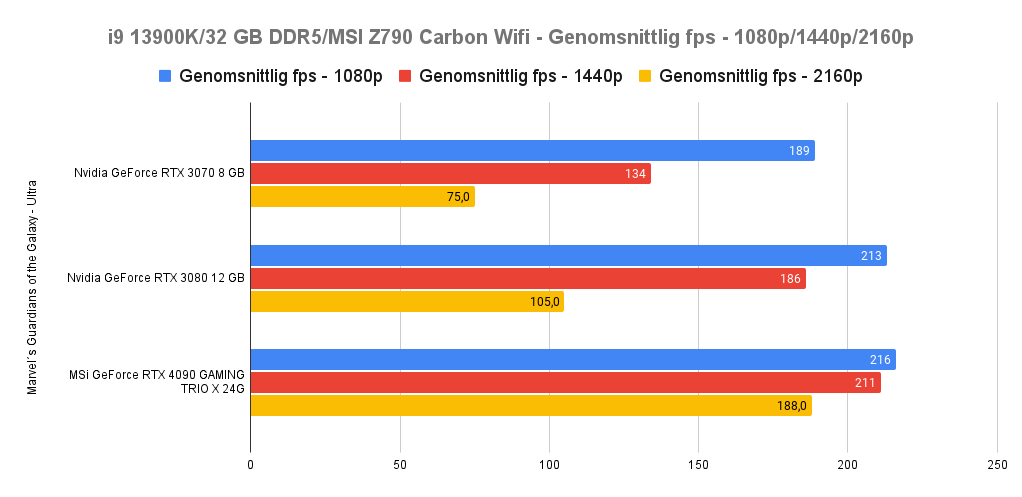

Marvel´s Guardians of the Galaxy (Ultra) i5 12600 vs i9 13900K

Som ett av de nyare spelen i listan genererar RTX 4090 inte någon nämnvärd ökning i FPS i de lägre upplösningarna jämfört med RTX 3080. Än en gång ser vi hur en svagare processor hämmar det monstruösa grafikkortet. Vi ser givetvis även grafikkortet CPU bundet på 1080p på i9 13900K, men då har den processorns råkraft gett 49% ökning från den äldre processorn – gen on gen.

Här är ett exempel på att det finns mer kraft att hämta ur RTX 4090 då det även i 4K verkar vara lite CPU bundet(!). Med andra ordet har vi inte sett taket på grafikkortet ännu, vilket innebär att framtida processorer kan innebära ytterligare ett lyft i FPS. Något som jag märkt på flera speltitlar i 4K för övrigt.

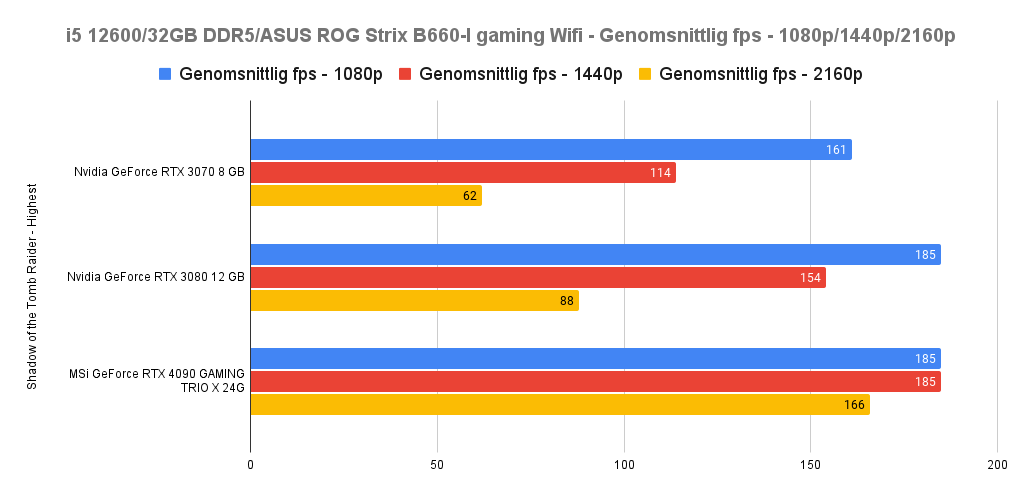

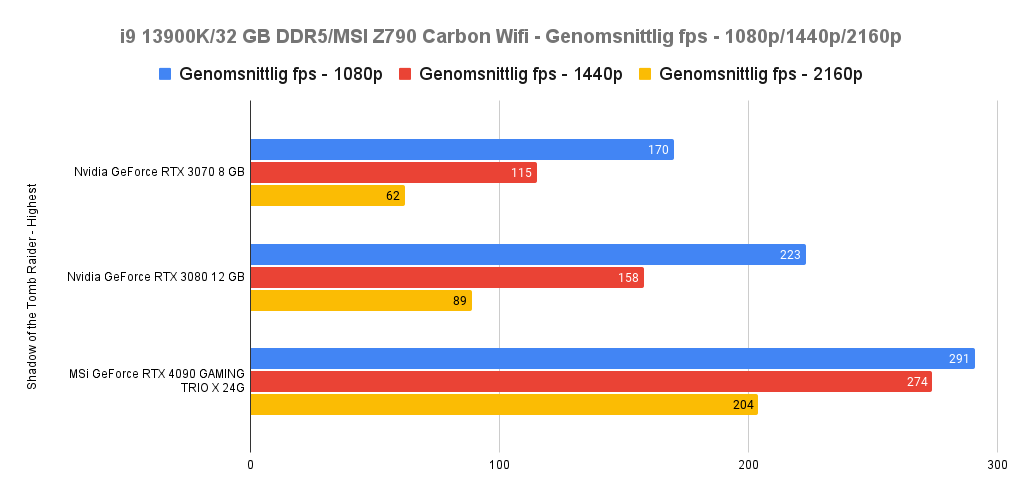

Shadow of the Tomb Raider (Highest) i5 12600 vs i9 13900K

Det äldre SoTR representerar alltmer den mängd av spel som fortfarande kan utmana grafikkort – men som samtidigt börjar visa sin ålder. Körandes på i5 12600 nåddes taket snabbt på 185 FPS i 1080p för både RTX 3080 och RTX 4090, men därefter ökade försprånget hos det senare kortet markant. Extra tydligt var i 2160p där RTX 4090 var 89% snabbare än RTX 3080! Och detta på en något äldre/svagare processor.

Men det var inget mot RTX 4090 körandes på i9 13900K där 4K gav en helt galen 129% ökning gentemot RTX 3080. Det var redan en otroligt stark utveckling enbart över i5 12600 processorn grafikkorten sinsemellan – men att få en ytterligare boost på cirka 23% om man jämför RTX 4090 körandes på de två processorerna säger en del.

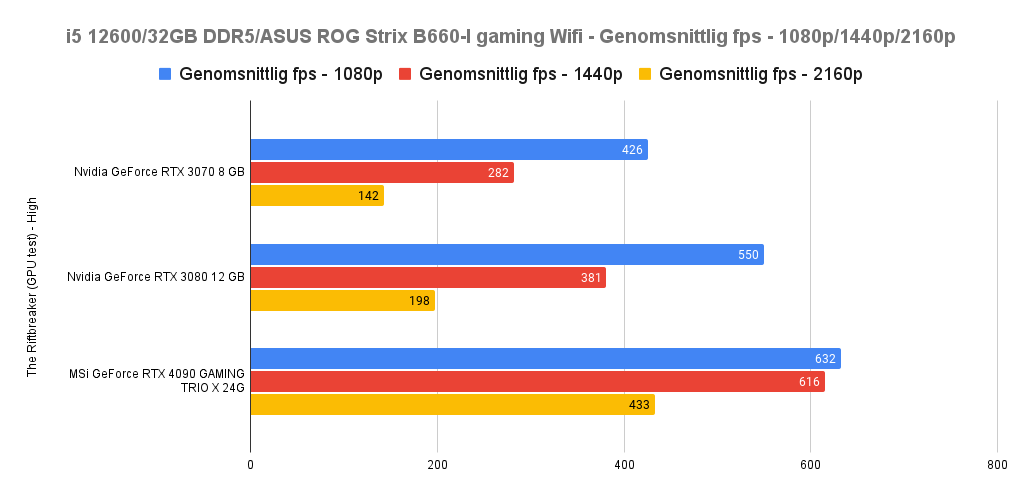

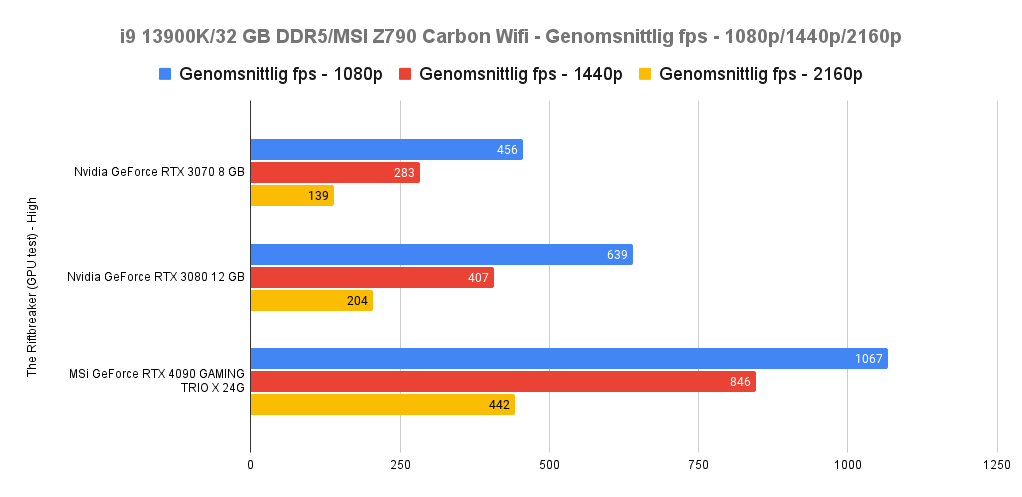

The Riftbreaker (GPU test) – (High – DirectX 11) i5 12600 vs i9 13900K

The Riftbreaker är ett lättare spel sett till det yttre och sin isometriska uppsyn – men kan trots det ändå vara ett respektabelt verktyg, särskilt i de lägre upplösningarna. Återigen ser vi hur i5 12600 är något CPU bunden på 1080p, men ser sedan tydlig utveckling på 1440p (61% över RTX 3080) och på 2160p (hela 119% över RTX 3080). Allt detta på en mer limiterande processor.

Återigen ser vi tecken på flaskhalsar om vi jämför RTX 4090 på i5 12600 och i9 13900K på 2160p, där vi ser mer återhållsam utveckling processorgenerationerna emellan.

Istället är det 1440p som har den mest intressanta utvecklingen, då vi ser hela 108% utveckling mellan RTX 3080 och RTX 4090 körandes på i9 13900K. Men även på den svagare i5 12600 har vi en markant ökning på nästan 70%! Med andra ord finns det vissa spel där 1440p får rejält med liv – och detta är ett av dem.

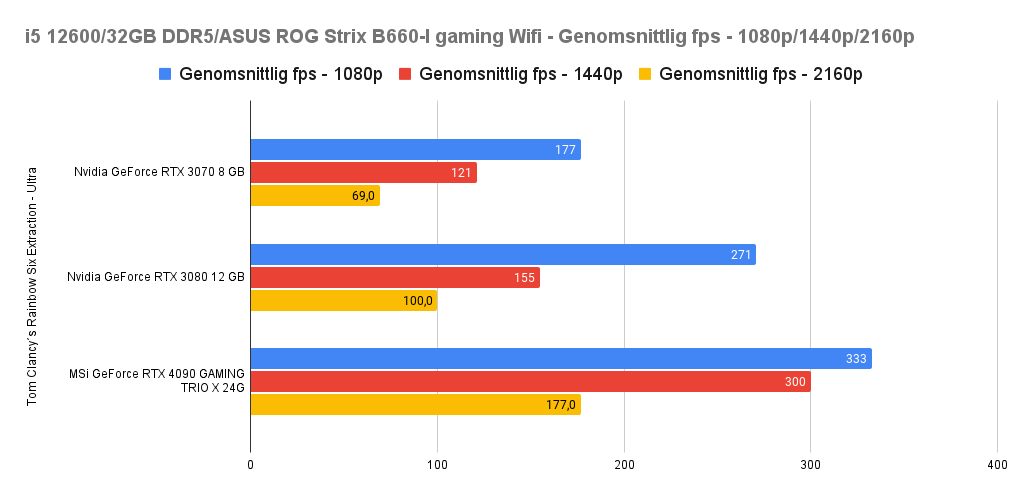

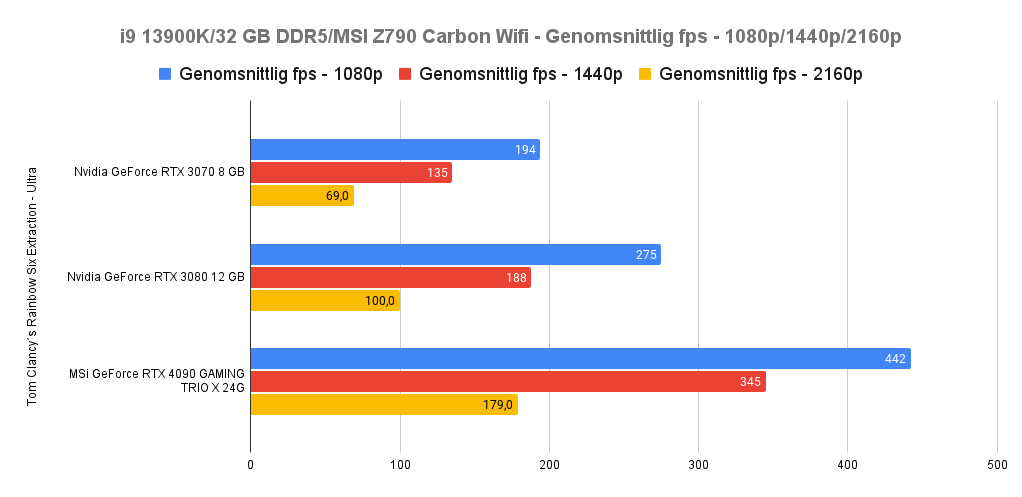

Tom Clancy´s Rainbow Six Extraction (Ultra) i5 12600 vs i9 13900K

Anvilmotorn som driver Rainbow Six Extraction är en optimerad och snabb sådan – vilket märks av på de flesta grafikkort. Att spelet kommer flyta på bra är därför redan vedertaget, frågan är bara hur snabbt. Därför är det intressant att vi ser 2160p toppas rejält i samtliga tester på samma likvärdig framerate – oavsett processor. Spelet utnyttjar åtminstone den starkare CPU-kraften hos i9 13900K, då vi ser 32% ökning jämtemot att köra RTX 4090 på i5 12600 i 1080p. Men sedan ”enbart” 15% ökning på 1440p om vi jämför RTX 4090 körandes mellan i5 12600 och i9 13900K.

På det stora hela presenterar spelet riktigt bra framerates över alla upplösningar – på samtliga processorer.

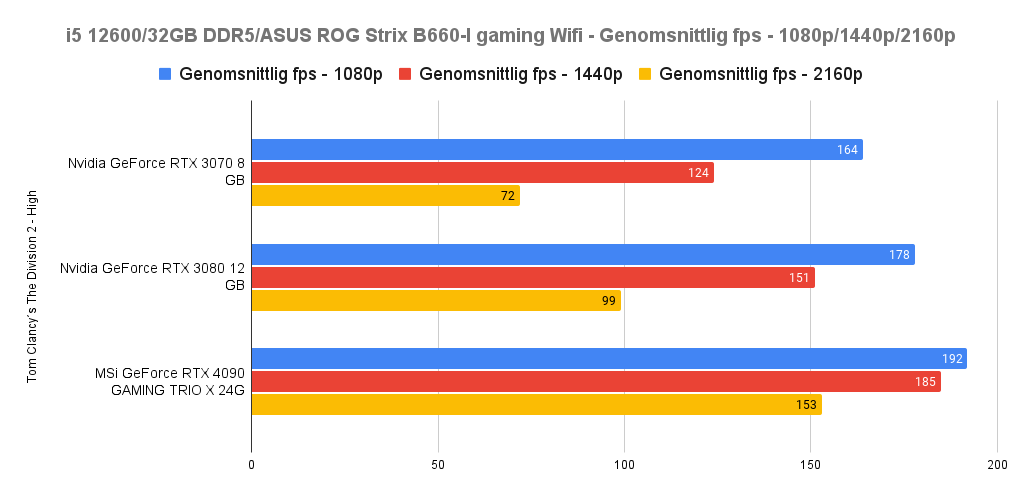

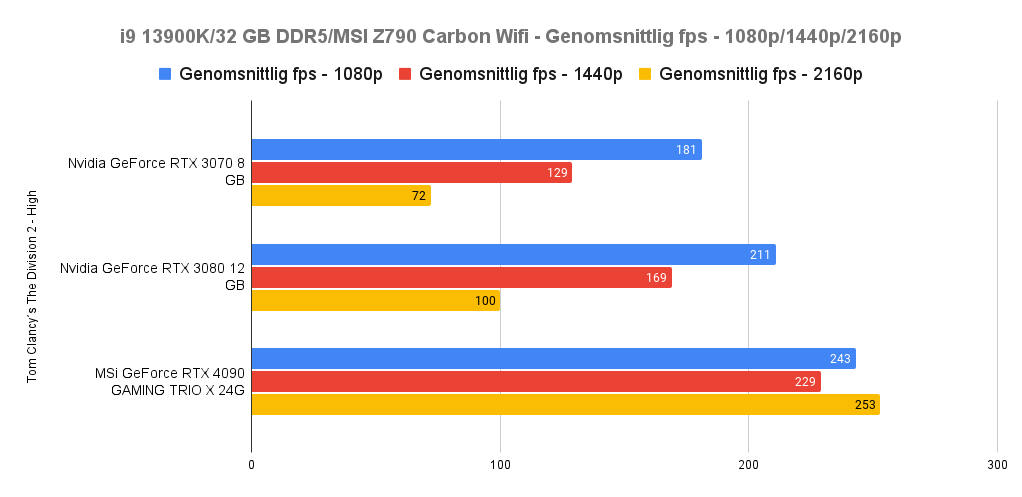

Tom Clancy´s The Division 2 (High) i5 12600 vs i9 13900K

Här kommer ytterligare ett spel som representerar de mer äldre spelen där ute. Samtidigt är det ett spel som optimerats i omgångar på grund av sin online-natur. Visst ser vi utveckling i runt 23-26 procent från RTX 3080 till RTX 4090 i 1080p och 1440p, men det är i 4K som de mer drastiska sådana märks av. På den svagare i5 12600 ser vi hela 53% ökning från RTX 3080 till 4090, men på den nyare i9 13900K processorn ser vi hela 153% ökning de korten emellan. Här har vi ett av de största utvecklingarna i våra tester, och visar på hur mycket extra kraft du kan få ut något äldre spel på något svagare processorer – men även hur du verkligen kan maxa allting skulle du längre fram uppgradera till en starkare processor.

Detta om något visar på det faktum att RTX 4090 har ett tak, och att det till viss del inte ens nått i flera av 4K prestandatesten.

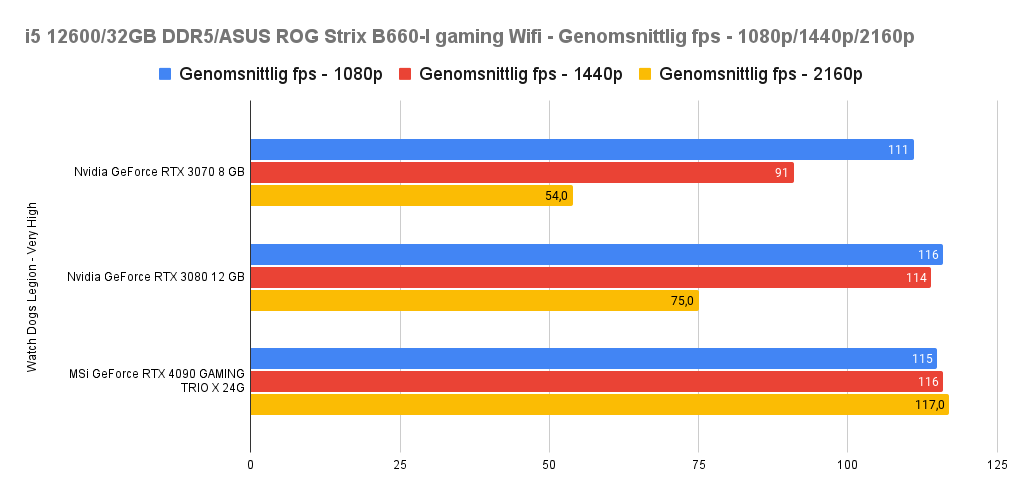

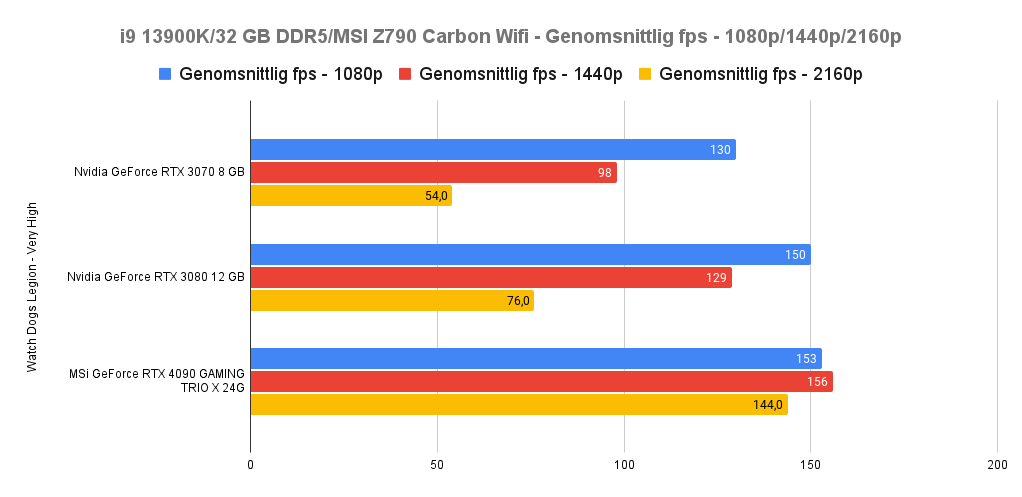

Watch Dogs Legion (Very High) i5 12600 vs i9 13900K

Slutligen kommer vi till Watch Dogs Legion, som bjuder på lite motstånd sett till hur krävande det är. Samtliga grafikkort var CPU bundna oavsett processor – och kom att differentiera sig först i 2160p. Spelet utnyttjar RTX 4090 särskilt väl i 4K (2160p som sagt) och är 56% snabbare än RTX 3080 körandes på i5 12600. Medan om du kör grafikkortet på en i9 13900K är skillnaden istället nästan 90% i 4K jämfört med RTX 3080. Ett spel som förut definitivt behövde justeras sett till grafikinställningar på RTX 3070 och till viss del på RTX 3080 – kan bara låtas drivas för vinden utan problem på RTX 4090. Den CPU bundna naturen av spelet, gjorde att det var först i 1440p via i9 13900K som det blev skillnad mellan RTX 3080 och RTX 4090. Med andra ord är RTX 4090 ett rejält tungt grafikkort som tröskar sig igenom de flesta spel – så länge processorn pallar det.

En total! – Generationsökning med råge!

Om vi samlar datan vi fått in på de elva spel som varit under luppen kommer här ett genomsnitt per upplösning (utifrån de 11 spelens insamlade data) – om vi använder i9 13900K och jämför med RTX 3080 – i hur mycket procentuell prestandaökning vi sett.

RTX 3080 till RTX 4090 i 1080p

Här ser vi någorlunda blygsamma 31,5% ökning i spelprestanda. Spelen är uppenbart CPU-bundna, men trots det ser vi ändå en tydlig utveckling. Den är bra, men inte bra nog för att 1080p spelare ska springa ut och köpa ett RTX 4090.

RTX 3080 till RTX 4090 i 1440p

Om vi tar ut genomsnittet av den procentuella ökning som skett om man går från RTX 3080 till RTX 4090 i 1440p ser vi hela 51,3% ökning. Detta är en betydligt mer imponerande siffra, och gör att kortet blir än mer intressant för 1440p spelare. Det är fortfarande viktigt att tänka över ett ev. köpbeslut då kostnaden är stor för 4090, men det är samtidigt en väldigt tydlig utveckling i prestanda.

RTX 3080 till RTX 4090 i 2160p (4K)

Den absolut tydligaste uppgången i prestanda sker i 4K, där de elva spelen får ett kombinerat genomsnitt av 90,3 % ökning om man går från RTX 3080 till RTX 4090. Denna typ av uppgång i prestanda är i våra ögon något som sker väldigt sällan och definitivt sätter detta grafikkort från MSi på kartan. Det gör inte bara att 4K spelande kommer upp i PC-spelares finrum, det gör att till och med Raytracing faktiskt kan bli en mer vardagligt användande sak sett till spelande. För kombinerar man exempelvis DLSS 2.0 och Raytracing finns alla möjligheter att få högt FPS-antal samtidigt som du driver spelet med högsta inställningarna OCH Raytracing. Något som egentligen var omöjligt tidigare.

DLSS 3.0 Frame Generation

Med en ny generation från Nvidia – har nu en ny DLSS teknik introducerats. Nåja, det är i ärlighetens namn inte så mycket en uppskalningsteknik som det är en frame-inskjutande lösning. Vad DLSS 3.0 gör om man förenklar det – är att det med hjälp av AI skapar en frame mellan två befintliga. På detta sätt kan du få högre framerate – även om den är artificiell egentligen.

Det finns givetvis mängder med tekniska detaljer kring hur detta fungerar, men då det är lite av en vetenskap låter jag det vara osagt. Men i korthet är det vad det låter som i namnet ”frame generation”. AI:n genererar en egengjord frame, och placerar den mellan två riktiga som ditt grafikkort sänder ut. Detta innebär att du kan få mycket högre FPS nivåer, men också att skärmsynkning (G-Sync, Freesync exempelvis) inte fungerar lika bra. Men då de inskjutna bildrutorna är något som inte känns av från bildskärmar sett, kommer vissa tydliga nackdelar.

- Screentearing.

Att detta sker är inte ovanligt för många grafikkort rent generellt. Men att det inte på ett bra sätt kan fixas med DLSS 3.0 är ett minus. Ja, du kan låsa grafikkortet med V-sync men det ökar bara nästa nackdel med tekniken. Nämligen… - Överdriven latens.

Då varje bildruta som skjuts in är något som articifiellt tas fram – innebär det att merparten bildrutor (frames) inte är påverkbara på samma sätt som en riktig sådan. Från det att du trycker på musknappen eller rör på tumspaken på handkontrollen ska denna rörelse aktiveras och visas på skärmen. Med dessa inskjutna bildrutor blir det påtagligt segare. Tack och lov motverkas detta av Nvidias teknik; Reflex – men är ändå något att ha i åtanke. - Artefakter i bilden.

Slutligen kan det påverka din upplevelse av spelet. I vårt fall märktes det mer ju lägre FPS du når. Ju lägre FPS, ju längre visas (om än i millisekunder) dessa inskjutna bildrutor och då de är artificiellt framtagna, kan deras artefakter vara tydligare. Det kan vara gränssnitt som inte återskapats korrekt, snabba områden som AI:n inte kunnat replikera alls – eller bara ovan latens/lagg.

Det är några av sakerna som Nvidia behöver se över – men med det sagt är det också bra att belysa styrkan med denna teknik. För det första blev det helt otroliga boosts i exempelvis Marvel´s Spider-Man Remastered, där tekniken verkar vara som mest finslipad. Att MSi:s 4090 Gaming X Trio dessutom är så starkt som det är, innebär att FPS-nivån blir enorm – i både 1440p och 4K. Med en hög FPS och ett finslipat spel som detta – märktes latens inte av alls lika mycket, och artefakterna kom att bli mindre uppmärksammade. Det var egentligen enbart när jag med hjälp av mus och tangentbord svingade snabbt åt höger och vänster i följd som artefakter runt armar och ben märktes av. Annars fungerade det riktigt bra – och blir därför (i alla fall för detta spel) ytterligare ett skäl att skaffa RTX 4090.

Ström/Nätaggregat!

När det kommer till strömförsörjning står MSi:s RTX 4090 Gaming X Trio ut extra mycket då den ”enbart” har tre sammanlöpande strömkablar att fästa på den strömadapter som medföljer. Skulle ni däremot ha ett PCIe 5.0/ATX 3.0 nätaggregat tillhanda, ja då behöver ni inte använda denna adapter. I skrivande stund finns det dock inte alls många sådana nätaggregat på den svenska marknaden, så se till att ha ett ordentligt och pålitligt sådant tillgängligt i datorn.

För RTX 4090 Gaming X Trio rekommenderas ett 850 W nätaggregat – något som i våra initiala tester dög alldeles utmärkt. Är det datorspelande som gäller hade vi aldrig något problem, och såg i våra tester att spelet som mest nådde 350W (enbart grafikkortet) i förbrukning. Grafikkortet kan nå högre watt-antal skulle ni göra mer krävande arbeten, såsom t.ex. 3D rendering och liknande, men för gemene gamer kommer det fungera bra.

Självklart skulle vi rekommendera att ni skaffar ett PCIe 5.0/ATX 3.0 nätaggregat (ex. som MSi MEG Ai1300P PCIE5 som snart också får en recension här på sajten) – dels för att vara säker uppåt i styrka, men också för att slippa adaptern och eventuell ansträngning därpå.

Omdömesmässigt kan vi bara avsluta denna del med att säga att 850W räcker gott och väl för i alla fall detta specifika grafikkort, och att det inte heller var något problem på den tyngre i9 13900K (vilket i sig är tämligen eltörstigt).

Utifrån prestanda enbart…

För att då börja runda av det hela, går det inte förneka vilken best MSi RTX 4090 Gaming X Trio är. Att taket etableras oftare på grund av processorn (till och med i vissa 4K scenarios) gör att det till och med finns svängrum att få ytterligare prestanda i framtiden. Det gömmer sig alltså mer prestanda har vi märkt, även körandes den i nuläget starkaste processorn: i9 13900K.

Detta grafikkort är inte till för er som enbart spelar i FullHD (1080p), men för 1440p och särskilt 4K känner jag att det finns extremt stort incitament. Detta är det första riktiga 4K grafikkort, där merparten av spel utan problem körs långt över 100 FPS – eller rentav 200 FPS. Att det är gjort för datorspelsentusiaster är tydligt och har du pengarna och intresset är det ett givet köp.

Bara utifrån dess råa kraft kan jag inte annat än att rekommendera den starkt. Jag har inte ens tagit upp ordinarie DLSS 2.0 som i mängder av spel utökar FPS-nivåerna markant även de, utöver det vi ser ovan i diagrammen. Kortet är så starkt att det på sätt och vis blir framtidssäkert, då det i detta nu får processorbundna scenarios till och med i 4K. Med andra ord kan framtida processorinköp eller högre RAM minnesmängd/hastighet innebära ytterligare ett lyft. Sen om det rör sig om 10-15 FPS över ordinarie eller inte, det beror på processor så klart. Men det är coolt att detta grafikkort finns, och att DLSS 3.0 introducerats. Den senare kommer säkerligen finslipas ytterligare och därmed bli än mer relevant ju längre tiden går.

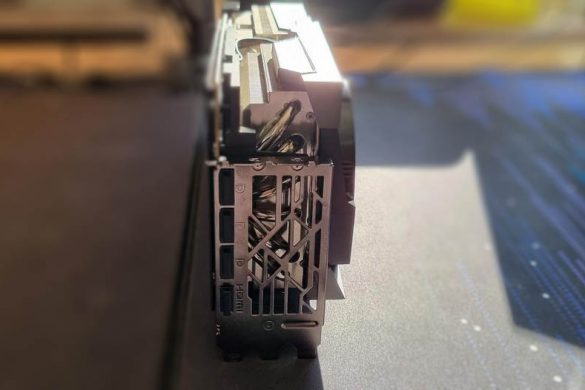

Värt att nämna! Kortets vikt är på över 2 kg, och därför rekommenderas det att du använder någon form av GPU ”Sag Bracket” – d.v.s. något som håller uppe det tunga grafikkort. Tur då att MSi adderat just detta med i paketet. Vi kom att använda en annan ”Sag bracket”. Dock kräver det utrymme under grafikkortet, så se till att ha ett stort nog chassi.

MSi:s medföljande GPU Sag Bracket är en rejäl pjäs som håller upp det tunga grafikkortet. Dock behöver du plats för det sett till chassiutrymme.

Utifrån prissättning enbart…

4K spelare må köpa detta grafikkort, men om du befinner dig på begränsad budget eller en väldigt gammal dator är det givetvis onödigt. Inte nog med att strömkraven är höga, kortet kostar över 24 000 kronor! Du kan köpa en riktigt bra dator för detta pris, så uppenbarligen är detta inte för alla. Och det vill jag vara tydlig med. Jag vill inte uppmuntra någon att skaffa detta om ni faktiskt inte spelar 4K/120FPS – eller åtminstone vill ha ett grafikkort att uppgradera tillsammans med (förutsatt att kostnaden noga övervägts). Priset är sjukt, det är sant och oavsett alla funktioner och prestanda kan jag inte säga att det är för alla… knappast för några få ens. Om ni vill ha mer ”bang for your bucks” (mervärde) skulle jag avvakta på AMD:s kommande RDNA 3 (i skrivande stund) för att se vad de presenterar. Eller framförallt avvakta på ett RTX 4060 eller RTX 4070. De korten kan vara betydligt smartare sett till att få valuta för pengarna. Sedan bara det faktum att du lämnar prestanda på bordet om du slår till med detta grafikkort om du har en något äldre dator, gör det än mer viktigt att tänka över eventuellt beslut och vara tålmodig. Det kommer fler grafikkort…

Allt detta sammanfaller då till slut med mina…

Avslutande ord

Som ni märker ovan så argumenterar jag både för och emot grafikkortet, och denna paradoxala natur är oerhört svår att recensera. Så till den grad att jag gått fram och tillbaka kring hur jag ska runda av recensionen sett till avslutande tankar.

Priset må vara löjligt, men samtidigt är det en riktad produkt mot en riktad publik. 4K spelare av denna typ finns där ute, och för dessa är detta kortet att ha. I alla fall just nu. Jag skulle avvakta tills AMD avslöjat RDNA 3 – bara för att få fler val – men utifrån detta korts rena prestanda kan jag inte annat än till slut böja mig för det.

Det går inte förneka det enorma generationshopp som skett, ej heller den råa kraft som finns i MSi Geforce RTX 4090 Gaming X Trio. Dess enorma form och vikt må vara något som kräver sitt chassi i storlek – men har du plats (och råd) är detta toppklass. Att testa Cyberpunk 2077 i 4K med DLSS 2.0 i ’quality’-läge och se spelet flyta fram i runt 144 FPS är sjukt. Men att även utan uppskalningsteknik se samtliga spel följsamma – med väldigt bra ’1% lows’ (vilket jag skippat pga tidsskäl denna gång) är otroligt imponerande och gör mig så spänd inför framtiden. Fast på ett sätt är framtiden redan här… i och med RTX 4090 Gaming X Trio!

| MODELLNAMN | GeForce RTX™ 4090 GAMING X TRIO 24G |

| GPU | NVIDIA® GeForce RTX™ 4090 |

| GRÄNSSNITT | PCI Express® Gen 4 |

| CORE CLOCKS | Extrem prestanda: 2610 MHz (MSI Center) Boost: 2595 MHz (SPEL & TYST läge) |

| CUDA ® KÄRNOR | 16384 Enheter |

| MINNESHASTIGHET | 21 Gbps |

| MINNE | 24GB GDDR6X |

| MINNESBUSS | 384-bitars |

| OUTPUT | DisplayPort x 3 (v1.4a) HDMI™ x 1 (stöder 4K@120Hz HDR, 8K@60Hz HDR och Variable Refresh Rate som specificeras i HDMI 2.1a) |

| HDCP-STÖD | Ja |

| ENERGIFÖRBRUKNING | 450 W |

| STRÖMKONTAKTER | 16-stift x 1 |

| REKOMMENDERAD PSU | 850 W |

| KORTETS MÅTT (MM) | 337 x 140 x 77 mm |

| VIKT (KORT/PAKET) | 2170 g / 3093 g |

| SUPPORT FÖR DIRECTX-VERSION | 12 Ultimate |

| OPENGL VERSIONSSTÖD | 4.6 |

| MAXIMALT ANTAL SKÄRMAR | 4 |

| G-SYNC ® -TEKNIK | Ja |

| DIGITAL MAXIMAL UPPLÖSNING | 7680 x 4320 |

Recensionsex tillhandahållet av MSi. Tillhandahållaren av produkten har inget inflytande över artikelns innehåll.

i samarbete med PriceRunner